El superchip Grace Hopper de Nvidia con CPU Arm y GPU Hopper está entrando en plena producción y listo para su entrega a los primeros clientes. Se puede construir una supercomputadora compatible con IA con el DGX GH200, que combina 256 superchips Grace Hopper para una sola potencia informática ExaFLOPS FP8 específicamente para IA.

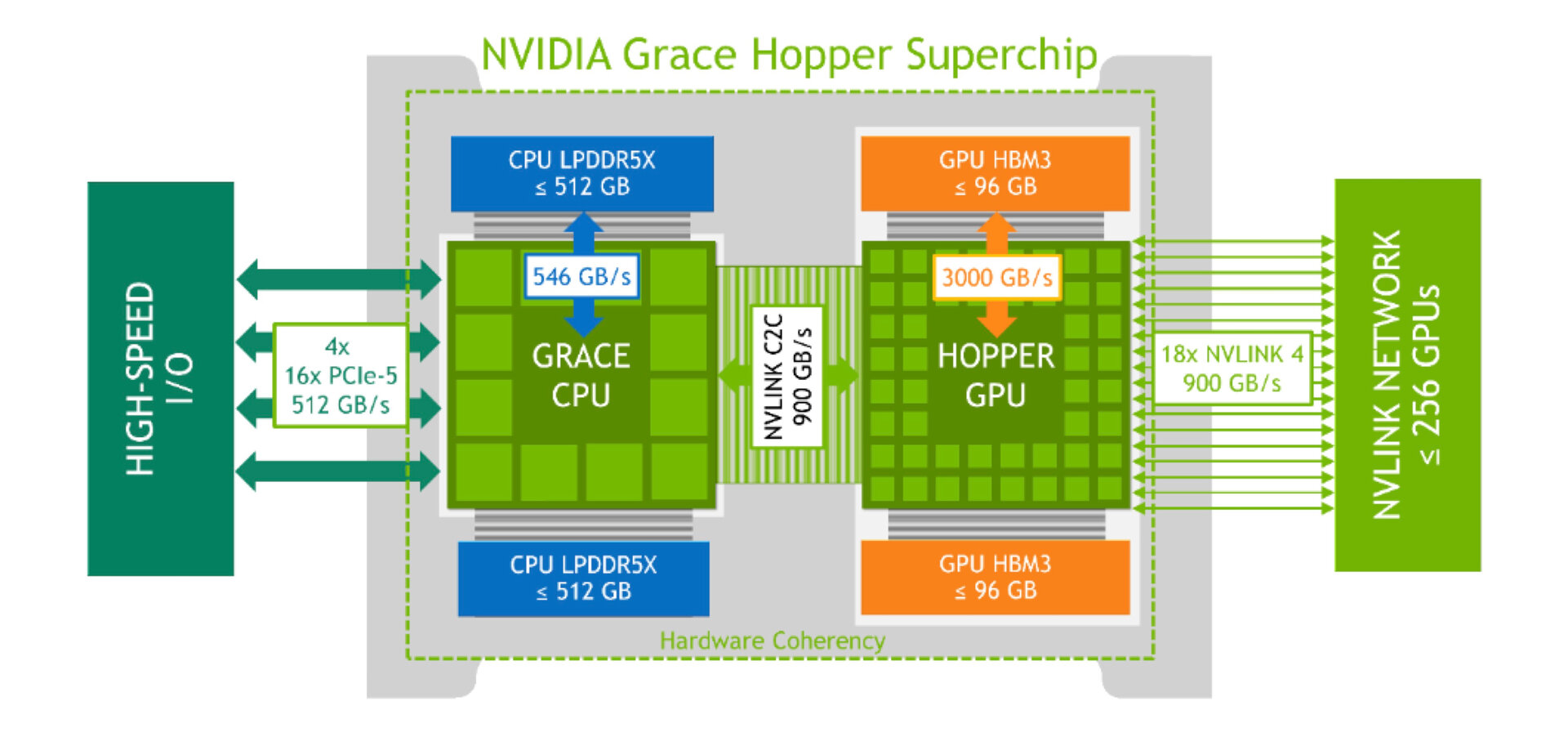

Con el CEO de Nvidia, Jensen Huang, anunciando el hito en Computex, Grace Hopper ahora tiene un número de modelo oficial por primera vez: el GH200. En el caso del superchip Grace Hopper, la arquitectura del superchip es una combinación de una CPU y una GPU ARM, que están conectadas a través de una interconexión interna de dos chips con un ancho de banda de 900 GB/s, que es siete veces el ancho de banda. Ancho de banda hasta el último PCIe Gen5 con 16 carriles. Con este estándar, el máximo es de 128 GB/s.

Nvidia presentó el superchip Grace Hopper por primera vez en el GTC en la primavera de 2021 y lo prometió para 2023, que ahora ha demostrado ser la predicción correcta. Nvidia tiene dos llamados superchips en su cartera: Grace Hopper Superchip y Grace Superchip, en los que se utiliza la interconexión de doble chip para el segundo brazo de la CPU. También se pueden flashear GPU externas.

DGX H200 utiliza 256 chips Grace Hopper superiores

Nvidia dejó claro en la feria comercial de Taiwán que los primeros sistemas con GH200 deberían estar disponibles este año. Por supuesto, Nvidia ha incluido uno de ellos en su cartera hoy: el DGX GH200 es una supercomputadora de IA prácticamente terminada que incluye 256 súper chips Grace Hopper en un solo sistema. Nvidia anuncia la supercomputadora con un rendimiento de 1 ExaFLOPS, que colocaría a la computadora en la liga principal del Top500, ya que un sistema Frontier de los EE. UU. logró romper esa marca recientemente.

Sin embargo, el cálculo de Nvidia para ExaFLOPS 1 especificado es un rendimiento por GPU H100 de 3958 TeraFLOPS para «FP8 Tensor Core» incl. acelerar la prosa Que es exactamente 1013 ExaFLOPS para 256 GPU. Para la entrada en el Top500 se utiliza el FP64, que es de solo 34 TFLOPS por superchip Grace Hopper. Por lo tanto, un DGX H200 llegará a 8704 PetaFLOPS, por lo que necesitará 115 DGX H200 o 29440 Grace Hopper para 1 ExaFLOPS en FP64. Sin embargo, usando un «FP64 Tensor Core» con instrucciones DMMA, esta información se puede duplicar (potencia) o reducir a la mitad (nodos). A modo de comparación: la PC Frontier más rápida utiliza 9472 conjuntos de chips AMD Epyc 7453 y 37 888 Radeon Instinct MI250X y obtiene 1194 ExaFLOPS.

Nvidia Helios utiliza cuatro DGX H200

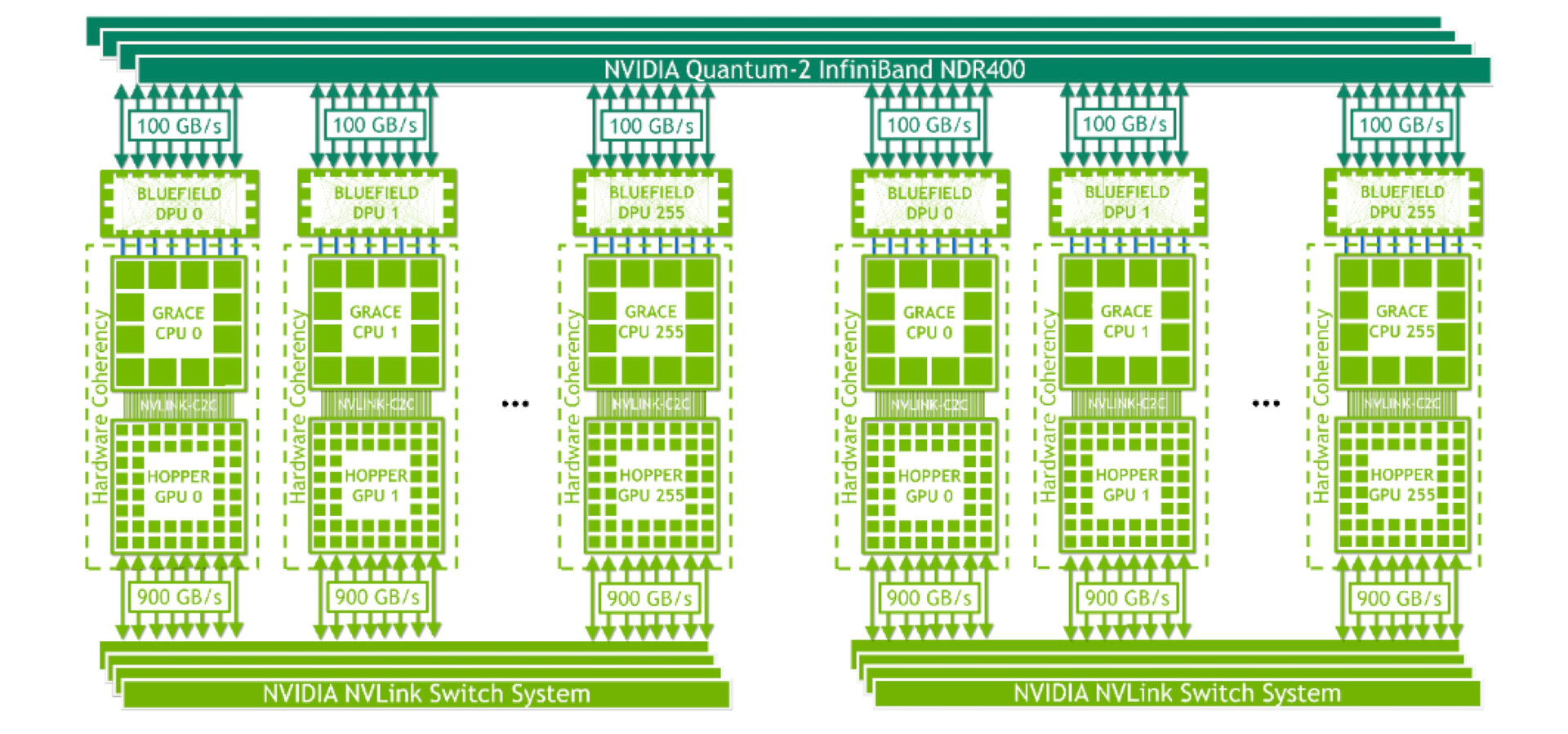

La interacción de los 256 superchips Grace Hopper en el DGX H200 ocurre a través de NVLink de cuarta generación, que también se ejecuta en la supercomputadora con 900 GB/s de una GPU a otra, que se maneja como una GPU masiva en el sistema a través de un interruptor NVLink. Los 96 GB por GPU de HBM3 dan como resultado 144 TB completos de memoria unificada. Sin embargo, ese no es el final de la historia, como lo demuestra la primera supercomputadora de Nvidia, la «Helios», que usó 1024 súper chips Grace Hopper y, por lo tanto, cuatro chips DGX H200. La DGX H200 está conectada en red a través de Quantum-2 InfiniBand, que aún alcanza los 400 GB/s por segundo y, por lo tanto, es casi la mitad del ancho de banda interno de la GPU. Según Nvidia, se supone que la supercomputadora Helios estará en línea a fines de este año.

Compromisos de Google, Meta y Microsoft

Nvidia ya ganó importantes compradores para la DGX H200 con Google, Meta y Microsoft. Grace Hopper Superchip se ha desarrollado específicamente para entrenar grandes modelos de IA, para IA generativa, sistemas de recomendación y análisis de datos y, por lo tanto, se adapta bien a las áreas de responsabilidad de las empresas mencionadas. El DGX GH200 también está diseñado para servir como modelo para que los proveedores de servicios en la nube personalicen aún más su infraestructura. Si bien los sistemas de terceros aún no se han anunciado, es probable que sigan más adelante y funcionen como HGX en lugar de DGX.

Fondo de pantalla de súper chip Grace Hopper

Súper chip Grace Hopper (PDF) consta de 72 núcleos Arm Neoverse V2 en el lado de la CPU, cada uno con 64 KB de caché I y D como caché L1 y 1 MB de caché L2 por núcleo. La caché L3 es de 117 MB. 480 GB de LPDDR5X con soporte ECC de 546 GB/s conectado a la CPU, y la CPU también ofrece cuatro PCIe Gen5 x16 para un total de 512 GB/s. Sin embargo, la GPU H100 está codificada a través de una conexión C2C con 900 GB/s y tiene un HBM3 de 96 GB con más de 3 TB/s de ancho de banda. 96 GB HBM3 corresponde a la mitad de la H100 NVL dual-GPU, pero por lo tanto el límite actual de Nvidia por GPU individual. El Grace Hopper Superchip se puede configurar de 450 a 1000 vatios TDP y refrigerado por aire o agua.

ComputerBase ha recibido información sobre este artículo de Nvidia en virtud de un acuerdo de confidencialidad. El único requisito era la fecha de publicación más temprana posible.

«Alborotador. Amante de la cerveza. Total aficionado al alcohol. Sutilmente encantador adicto a los zombis. Ninja de twitter de toda la vida».